8. Unterrichtsblock

Kursinhalte

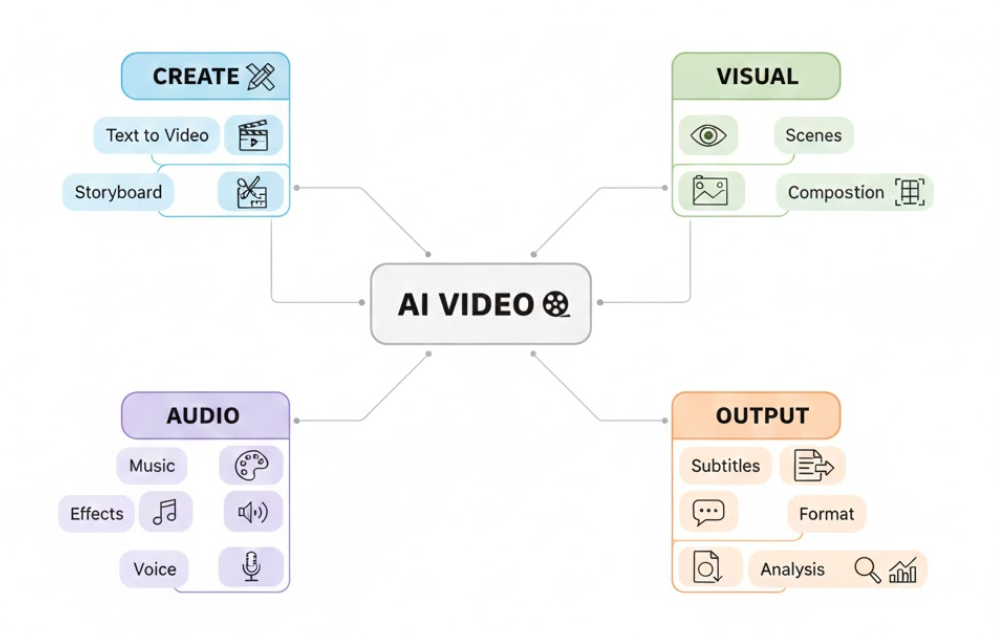

- Was ist KI-Videoproduktion

- Technik hinter KI-Videoproduktion

- Kostenlose KI-Videotools

- Deepfakes

KI-Videoproduktion

Einführung: Was ist KI-Videoproduktion?

KI-Videoproduktion bezeichnet die Erstellung, Bearbeitung oder Planung von Videos mithilfe künstlicher Intelligenz. Dabei übernimmt die KI Aufgaben, die früher manuell erledigt wurden – z. B.:

- Text-zu-Video: Wandelt Skripte oder Prompts direkt in animierte Szenen um

- Storyboard-Erstellung: Generiert visuelle Ablaufpläne aus Texten oder Ideen

- Szenenauswahl & Bildkomposition: Entscheidet automatisch über Perspektive, Licht, Bewegung

- Stilwahl & visuelle Effekte: Wendet visuelle Stile an (z. B. Cartoon, Cinematic, Retro)

- Schnitt & Übergänge: Schneidet Szenen, fügt Übergänge und Rhythmus ein

- Musik & Sounddesign: Wählt passende Musik, Geräusche oder Soundeffekte aus

- Text-zu-Sprache (TTS): Erzeugt synthetische Sprecherstimmen mit Emotion und Tonlage

- Avatar-Animation: Lässt virtuelle Figuren sprechen und sich bewegen

- Gesichtssynchronisation: Passt Mimik und Lippenbewegung an gesprochene Texte an

- Automatische Untertitelung: Erstellt und synchronisiert Untertitel aus Audio oder Text

- Formatanpassung: Optimiert Videos für Plattformen wie TikTok, YouTube, Instagram

- Inhaltsanalyse: Erkennt Themen, Stimmungen oder Zielgruppen im Video

- Feedback & Optimierung: Bewertet Wirkung und schlägt Verbesserungen vor

- Datenvisualisierung: Zeigt Entscheidungsprozesse oder Stilparameter grafisch an

Ziel ist es, die Videoproduktion schneller, zugänglicher und kreativer zu machen – auch für Menschen ohne professionelle Schnittsoftware oder Kameraequipment. KI-Videos werden heute z. B. für Präsentationen, Marketing, Tutorials oder Social Media eingesetzt.

Aufgabe

Teil A: Schaut euch folgende Kurzvideos an und beantwortet die Fragen:

- Was fällt euch beim ersten Eindruck auf? → Atmosphäre, Bewegung, Licht, Ton, Details

- Welche Unterschiede erkennt ihr zwischen Video A und Video B? → z. B. bei Perspektive, Realismus, Dynamik, Bildtiefe

- Würdet ihr Video B auch ohne Markierung als KI-generiert erkennen? Warum (nicht)?

- Was wirkt glaubwürdig – was eher künstlich oder inszeniert?

- Welche Vorteile hat ein KI-Video gegenüber einem echten Clip? Und welche Nachteile?

- Wo würdet ihr ein KI-Video einsetzen – und wo lieber nicht?

Teil B: Stell dir vor, KI-Videotools wie Pika, Runway oder Synthesia werden in der Filmbranche flächendeckend eingesetzt. Überlege, welche Auswirkungen das auf die Arbeit von Filmschaffenden haben könnte.

Fragen zur Reflexion (schriftlich oder mündlich):

- Welche Berufe könnten sich verändern oder wegfallen?

- Welche neuen Möglichkeiten entstehen für kleine Studios oder Einzelpersonen?

- Wie könnte sich die Qualität oder Kreativität von Filmen verändern?

- Was bedeutet das für Schauspieler:innen, Cutter:innen oder Drehbuchautor:innen?

- Sollte KI in Filmen gekennzeichnet werden?

Technik hinter KI-Videoproduktion

KI-Videoproduktion basiert auf komplexen technischen Prozessen, die aus Texten, Daten und Parametern automatisch visuelle Inhalte erzeugen. Dabei kommen verschiedene Komponenten zum Einsatz, die miteinander verzahnt arbeiten:

Text-to-Video

Ein Text-to-Video-Modell nutzt künstliche Intelligenz, um aus einer schriftlichen Beschreibung automatisch ein Video zu erzeugen. Der Prozess läuft in mehreren Schritten ab:

- Optional: Ton & Stimme Je nach Tool kann die KI auch passende Musik, Geräusche oder eine synthetische Sprecherstimme hinzufügen, die den Text vorliest.

- Texteingabe (Prompt) Die Nutzerin oder der Nutzer gibt eine Beschreibung ein – z. B. „Ein Fuchs läuft durch einen verschneiten Wald bei Sonnenuntergang“.

- Sprachverarbeitung (NLP) Die KI analysiert den Text mithilfe von Natural Language Processing (NLP). Sie erkennt Schlüsselbegriffe (z. B. Fuchs, Wald, Sonnenuntergang) und interpretiert deren Bedeutung im Kontext.

- Szenenplanung Die KI entscheidet, welche visuellen Elemente zum Text passen. Sie wählt z. B. Landschaft, Lichtstimmung, Bewegung, Perspektive und Farbpalette aus.

- Bildgenerierung & Animation Die KI erzeugt einzelne Bildsequenzen oder Frames, oft mithilfe von Bildgeneratoren (ähnlich wie bei Text-to-Image). Diese werden animiert, um Bewegung und Dynamik zu erzeugen.

- Zusammenstellung zum Video Die animierten Szenen werden zu einem Video zusammengesetzt. Die KI fügt Übergänge, Kamerafahrten oder Effekte hinzu – je nach Stilvorgabe oder automatischer Bewertung.

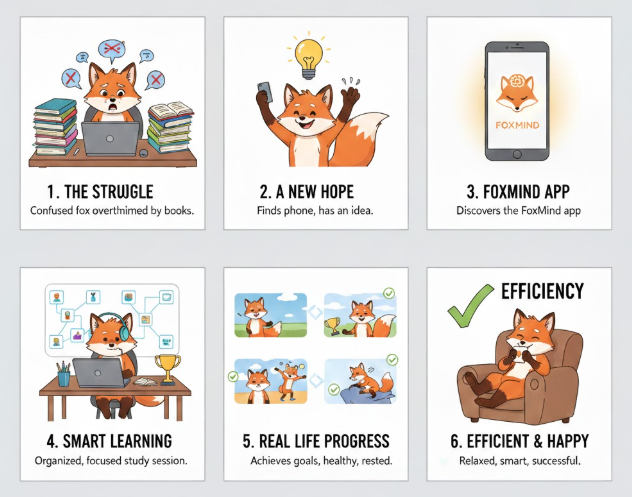

Storyboard-Erstellung mit KI

Ein Storyboard ist eine visuelle Vorschau auf ein geplantes Video. Es zeigt Szene für Szene, was im Video passieren soll – ähnlich wie ein Comicstrip oder Ablaufplan. In der KI-Videoproduktion kann ein Storyboard automatisch oder halbautomatisch aus einem Text oder Skript erstellt werden.

- Texteingabe Die Nutzerin oder der Nutzer gibt ein Skript, eine Beschreibung oder ein Prompt ein – z. B. „Ein Fuchs läuft durch einen verschneiten Wald bei Sonnenuntergang.“

- Szenenzerlegung Die KI zerlegt den Text in einzelne Handlungsschritte oder Szenen. Jede Szene bekommt eine eigene visuelle Einheit.

- Bildvorschläge & Perspektiven Für jede Szene schlägt die KI passende Bilder, Kameraperspektiven oder visuelle Stimmungen vor – z. B. Nahaufnahme, Vogelperspektive, Gegenlicht.

- Anordnung & Ablauf Die Szenen werden in zeitlicher Reihenfolge angeordnet. Das Storyboard zeigt, wie das Video aufgebaut ist – z. B. Anfang, Übergänge, Höhepunkt, Schluss.

- Optional: Text & Ton Zu jeder Szene können Sprechertexte, Soundideen oder Musikvorschläge ergänzt werden.

Szenenauswahl

Die KI erkennt Schlüsselbegriffe und Handlungsverläufe im Text und wählt passende Szenen aus. Dabei berücksichtigt sie:

- Ort: z. B. Wald, Stadt, Innenraum

- Zeit: z. B. Tag, Nacht, Sonnenuntergang

- Handlung: z. B. „läuft“, „spricht“, „tanzt“

- Stimmung: z. B. ruhig, spannend, fröhlich

Bildkomposition

Die Bildkomposition beschreibt, wie die Szene visuell aufgebaut ist. Die KI entscheidet über:

- Kameraperspektive: z. B. Nahaufnahme, Vogelperspektive, Schwenk

- Bildaufbau: Position von Figuren, Objekten, Hintergrund

- Farbgestaltung: z. B. warme vs. kalte Töne, Kontraste

- Bewegung & Dynamik: z. B. langsamer Zoom, schnelle Schnitte

- Licht & Schatten: z. B. Gegenlicht, diffuse Beleuchtung

Stilwahl

Die Stilwahl bestimmt die ästhetische Gestaltung des Videos. Beispiele für Stilrichtungen:

- Realistisch: natürliche Farben, echte Lichtverhältnisse

- Cinematic: filmische Optik mit Tiefenschärfe, Kontrasten und Kamerabewegung

- Cartoon/Anime: vereinfachte Formen, kräftige Farben, stilisierte Bewegungen

- Retro/Vintage: Farbfilter, Körnung, Lichtreflexe im Stil vergangener Jahrzehnte

- Surreal/Fantasy: übertriebene Farben, ungewöhnliche Perspektiven, Traumlogik

Die Stilwahl kann durch den Prompt gesteuert werden – z. B. „im Stil eines Zeichentrickfilms“ oder „wie ein Kinotrailer“.

Visuelle Effekte

Visuelle Effekte ergänzen die Szenen und sorgen für Dynamik, Atmosphäre oder Übergänge. Beispiele:

- Bewegungseffekte: Zoom, Kameraschwenk, Zeitlupe

- Licht- & Farbfilter: Sonnenuntergangsstimmung, Nachtmodus, Neonlicht

- Übergänge: Blenden, Wischen, Auflösen

- Text- & Grafikeinblendungen: Titel, Untertitel, Symbole

- Stilüberlagerungen: z. B. Glitch-Effekt, VHS-Optik, Comic-Raster

Die KI wendet diese Effekte automatisch an oder auf Basis von Stilvorgaben im Prompt.

Schnitt (Editing)

Der Schnitt bestimmt, welche Szenen gezeigt werden, wie lange sie dauern und in welcher Reihenfolge sie erscheinen. Die KI entscheidet dabei:

- Szenenauswahl: Welche Bildsequenzen sind relevant?

- Timing: Wie lange bleibt eine Szene sichtbar?

- Kürzen & Entfernen: Unwichtige oder redundante Inhalte werden automatisch entfernt

- Rhythmus: Schnelle Schnitte für Spannung, langsame Schnitte für Ruhe

- Synchronisation: Abstimmung von Bild, Ton und Sprechertext

Beispiel: Ein KI-Tool erkennt, dass eine Szene zu lang ist und kürzt sie automatisch, um die Aufmerksamkeit zu halten.

Übergänge (Transitions)

Übergänge verbinden Szenen visuell und sorgen für einen flüssigen Ablauf. Die KI wählt passende Übergänge je nach Stil und Inhalt:

- Visuelle Blenden: z. B. Überblenden, Schwarzblende, Wischen

- Kamerabewegungen: z. B. Zoom, Schwenk, Perspektivwechsel

- Stilwechsel: z. B. von realistisch zu cartoonartig

- Tonübergänge: z. B. Musikfade, Soundeffekt als Brücke

- Thematische Verknüpfung: z. B. gleiche Farben oder Formen als Übergangselement

Die Übergänge beeinflussen, ob ein Video ruhig, dynamisch, dramatisch oder spielerisch wirkt.

Musikgenerierung

KI kann passende Musik auswählen oder sogar selbst komponieren – basierend auf:

- Stimmung des Videos: z. B. ruhig, spannend, fröhlich

- Genre-Vorgaben: z. B. Pop, Klassik, Ambient

- Bildinhalten: z. B. Natur, Stadt, Bewegung

- Schnitt-Rhythmus: Musik wird synchronisiert mit Szenenwechseln

Beispiel: Ein KI-Tool erkennt eine langsame Kamerafahrt durch einen Wald und wählt eine ruhige, atmosphärische Musikspur.

Sounddesign

Sounddesign umfasst Geräusche, Effekte und akustische Details, die das Video lebendig machen. Die KI kann:

- Umgebungsgeräusche hinzufügen: z. B. Wind, Schritte, Vogelstimmen

- Soundeffekte platzieren: z. B. Feuerknistern, Türknarren, digitale Blips

- Tonübergänge gestalten: z. B. Fade-in/Fade-out, Echo, Verzerrung

- Synchronisation mit Bild: z. B. Geräusch beim Bewegungsstart

Text-to-Speech (TTS) in KI-Videoproduktion

Text-to-Speech (TTS) ist ein KI-gestütztes Verfahren, bei dem geschriebener Text automatisch in gesprochene Sprache umgewandelt wird. In der Videoproduktion ermöglicht TTS die schnelle und flexible Vertonung von Videos – ohne Mikrofon, Sprecher:innen oder Tonstudio.

- Texteingabe Die Nutzerin oder der Nutzer gibt einen Sprechertext ein – z. B. „Willkommen zu unserem Video über KI im Alltag.“

- Sprachauswahl Die KI bietet verschiedene Stimmen, Sprachen, Tonlagen und Sprechstile zur Auswahl – z. B. männlich/weiblich, freundlich, sachlich, emotional.

- Sprachsynthese Die KI analysiert den Text und erzeugt eine synthetische Stimme, die den Text flüssig und natürlich spricht. Dabei werden Betonung, Pausen und Rhythmus automatisch angepasst.

- Integration ins Video Die erzeugte Stimme wird mit dem Bildmaterial synchronisiert – z. B. mit einem Avatar, einer Szene oder einem Infotext.

Avatar-Animation in KI-Videoproduktion

Avatar-Animation bezeichnet die automatische Erzeugung und Bewegung virtueller Figuren, die in einem Video sprechen, gestikulieren oder agieren. KI-gestützte Tools wie Synthesia, D-ID oder HeyGen ermöglichen die Erstellung solcher Avatare aus Texten – ohne Kamera, Schauspieler:innen oder Motion-Capture.

- Texteingabe (Skript) Die Nutzerin oder der Nutzer gibt einen Sprechertext ein – z. B. für ein Erklärvideo oder eine Präsentation.

- Avatar-Auswahl Die KI bietet verschiedene virtuelle Figuren zur Auswahl – z. B. realistisch, cartoonartig, neutral, emotional. Einige Tools erlauben sogar das Hochladen eigener Avatare.

- Sprachsynthese (TTS) Der Text wird in gesprochene Sprache umgewandelt (Text-to-Speech), inklusive Tonlage, Tempo und Emotion.

- Gesichts- & Lippenbewegung Die KI synchronisiert Mimik und Lippenbewegung mit dem gesprochenen Text – oft in Echtzeit oder Frame-basiert.

- Gestik & Blickrichtung Je nach Tool kann der Avatar zusätzlich gestikulieren, nicken, lächeln oder die Blickrichtung ändern – passend zur Aussage.

- Integration ins Video Der animierte Avatar wird in das Video eingebettet – z. B. vor einem Hintergrund, mit Texten oder Grafiken.

Gesichtssynchronisation in KI-Videoproduktion

Gesichtssynchronisation bezeichnet die automatische Abstimmung von Mimik, Lippenbewegung und Gesichtsausdruck mit gesprochenem Text oder Ton. In KI-Videotools wird diese Technik genutzt, um virtuelle Avatare oder animierte Figuren glaubwürdig sprechen zu lassen – ohne Schauspieler:innen oder Motion-Capture.

- Texteingabe oder Audio Die KI erhält einen Sprechertext (Text-to-Speech) oder eine echte Tonaufnahme.

- Sprachanalyse Die KI analysiert den Rhythmus, die Betonung und die Silbenstruktur des gesprochenen Textes.

- Lippensynchronisation Die Lippenbewegungen des Avatars werden framegenau an die Sprache angepasst – z. B. Öffnen, Schließen, Formung bei „O“, „M“, „E“ usw.

- Mimik & Ausdruck Zusätzlich werden Gesichtsausdrücke wie Lächeln, Stirnrunzeln oder Augenbewegungen eingeblendet – passend zur Emotion im Text.

- Synchronisation mit Bild Die KI stimmt alle Bewegungen mit dem Videobild ab, sodass die Figur glaubwürdig wirkt – z. B. bei Präsentationen, Erklärvideos oder Dialogszenen.

Automatische Untertitelung in KI-Videoproduktion

Automatische Untertitelung bezeichnet den KI-gestützten Prozess, bei dem gesprochene Inhalte eines Videos erkannt, transkribiert und als synchronisierte Textzeilen eingeblendet werden. Sie verbessert die Zugänglichkeit, Verständlichkeit und Mehrsprachigkeit von Videoinhalten.

- Spracherkennung (Speech-to-Text) Die KI analysiert das Audio des Videos und wandelt gesprochene Sprache in geschriebenen Text um – inklusive Pausen, Betonungen und Satzstruktur.

- Zeitcodierung (Timestamping) Jede Textzeile wird mit einem Zeitstempel versehen, sodass sie exakt zur gesprochenen Passage eingeblendet wird.

- Sprachmodell & Korrektur Die KI nutzt trainierte Modelle, um Dialekte, Fachbegriffe oder undeutliche Aussprache zu erkennen und automatisch zu korrigieren.

- Einblendung im Video Die Untertitel werden visuell eingebettet – z. B. als Lauftext, Blocktext oder mehrsprachige Auswahl.

Formatanpassung in KI-Videoproduktion

Formatanpassung bezeichnet die automatische Optimierung eines Videos für verschiedene Plattformen, Bildschirmgrößen oder Zielgruppen. KI-gestützte Tools erkennen Anforderungen und passen das Video entsprechend an – ohne manuelle Nachbearbeitung.

- Plattformanalyse Die KI erkennt, für welche Plattform das Video gedacht ist – z. B. YouTube, TikTok, Instagram, Website, Präsentation.

- Seitenverhältnis & Auflösung Das Video wird automatisch in das passende Format gebracht:

- 16:9 für YouTube oder Präsentationen

- 9:16 für TikTok oder Instagram Stories

- Quadratisch (1:1) für Instagram Feed

- 4:3 oder 21:9 für spezielle Anwendungen

- Bildkomposition & Zuschnitt Die KI verschiebt oder skaliert Bildinhalte, damit wichtige Elemente im neuen Format sichtbar bleiben – z. B. zentrierte Personen, Textfelder oder Logos.

- Text- & Grafikanpassung Untertitel, Titel und Grafiken werden neu positioniert oder skaliert, damit sie im Zielformat lesbar und ästhetisch sind.

- Ton & Rhythmus Musik, Sprechertext und Schnitte werden ggf. angepasst, um zur neuen Videolänge oder zum Format zu passen – z. B. kürzere Version für Social Media.

Inhaltsanalyse in KI-Videoproduktion

Inhaltsanalyse bezeichnet die Fähigkeit von KI-Systemen, den Inhalt eines Videos automatisch zu erkennen, zu strukturieren und zu bewerten. Dabei werden visuelle, auditive und textuelle Elemente analysiert, um Aussagen über Thema, Stimmung, Zielgruppe oder Qualität zu treffen.

- Multimodale Erkennung Die KI verarbeitet Bild, Ton und Text gleichzeitig – z. B. Szenenbilder, Sprechertext, Musik, Geräusche.

- Themenklassifikation Die KI erkennt, worum es im Video geht – z. B. „Sport“, „Technik“, „Tutorial“, „Emotionale Geschichte“.

- Stimmungsanalyse Durch Tonlage, Musik, Farben und Sprache wird die emotionale Wirkung eingeschätzt – z. B. „fröhlich“, „dramatisch“, „neutral“.

- Zielgruppenbewertung Die KI analysiert Sprache, Tempo, Bildsprache und Format, um zu beurteilen, für wen das Video geeignet ist – z. B. „Jugendliche“, „Fachpublikum“, „Allgemeinheit“.

- Strukturerkennung Die KI erkennt Aufbau und Gliederung – z. B. Einleitung, Hauptteil, Schluss, Call-to-Action.

- Feedback & Optimierung Auf Basis der Analyse kann die KI Vorschläge zur Verbesserung machen – z. B. „Intro zu lang“, „Ton zu leise“, „Stimmung nicht klar“.

Feedback & Optimierung in KI-Videoproduktion

Feedback & Optimierung bezeichnet die Fähigkeit von KI-Systemen, ein Video nach der Erstellung zu analysieren und gezielte Verbesserungsvorschläge zu machen. Dabei werden technische, visuelle und inhaltliche Aspekte bewertet – automatisch, datenbasiert und oft in Echtzeit.

- Inhaltsanalyse Die KI erkennt Struktur, Thema, Stimmung und Zielgruppe des Videos (siehe Konzept „Inhaltsanalyse“).

- Qualitätsbewertung Die KI prüft technische Merkmale wie:

- Bildschärfe, Lichtverhältnisse, Farbkontraste

- Tonqualität, Lautstärke, Hintergrundgeräusche

- Synchronisation von Bild und Ton

- Lesbarkeit von Texten und Untertiteln

- Wirkungsanalyse Die KI bewertet, wie das Video auf Zuschauer:innen wirken könnte:

- Ist die Botschaft klar?

- Ist der Einstieg spannend genug?

- Passt die Musik zur Stimmung?

- Ist die Länge angemessen?

- Optimierungsvorschläge Die KI schlägt konkrete Verbesserungen vor, z. B.:

- „Intro kürzen für bessere Aufmerksamkeit“

- „Tonspur angleichen – Musik überlagert Sprechertext“

- „Farbfilter anpassen – wirkt zu düster für Zielgruppe“

- „Textgröße erhöhen – besser lesbar auf mobilen Geräten“

- Automatische Anpassung In manchen Tools kann die KI die vorgeschlagenen Änderungen direkt umsetzen – z. B. Schnitt, Tonanpassung, Formatwechsel.

Datenvisualisierung in KI-Videoproduktion

Datenvisualisierung bezeichnet die grafische Darstellung von Informationen, Parametern oder Entscheidungsprozessen innerhalb der KI-Videoproduktion. Sie macht komplexe Abläufe sichtbar und hilft dabei, die Funktionsweise von KI-Modellen besser zu verstehen und zu reflektieren.

- Visualisierung interner Parameter KI-Modelle arbeiten mit Wahrscheinlichkeiten, Gewichtungen und Vektorwerten. Diese lassen sich z. B. als Balkendiagramme, Heatmaps oder Netzwerke darstellen.

- Entscheidungslogik sichtbar machen Die KI trifft Entscheidungen – z. B. welche Szene, welcher Stil, welche Musik. Diese Logik kann als Entscheidungsbaum, Wenn-Dann-Regel oder Clusterbild visualisiert werden.

- Prompt-Analyse Tools zeigen, wie ein Text-Prompt interpretiert wird – z. B. welche Begriffe besonders bildwirksam sind oder welche Emotionen erkannt wurden.

- Stil- und Stimmungsparameter Farbpaletten, Bewegungstypen oder Musikstile können als visuelle Skalen oder Diagramme dargestellt werden – z. B. „Stimmungsachse von ruhig bis dramatisch“.

- Feedback & Optimierung KI-Tools visualisieren Verbesserungsvorschläge – z. B. „Intro zu lang“, „Ton zu laut“, „Stil nicht konsistent“ – oft als Ampelsystem oder Score-Karte.

Image to Video

Image-to-Video bezeichnet die KI-gestützte Umwandlung eines einzelnen Bildes in ein kurzes Video. Dabei wird das Bild entweder:

- animiert (z. B. ein Porträt beginnt zu sprechen oder blinzeln)

- in Bewegung versetzt (z. B. Kameraflug über eine Landschaft)

- stilistisch erweitert (z. B. ein Gemälde wird zu einer Szene mit Licht und Tiefe)

Typische Anwendungen

| Anwendung | Beispiel |

|---|---|

| Gesichtsanimation | Ein Porträt beginnt zu sprechen oder zeigt Mimik (z. B. mit D-ID, HeyGen) |

| Kameraflug über ein Bild | Ein statisches Bild wird mit Zoom, Schwenk oder Tiefenwirkung versehen |

| Stilistische Bewegung | Ein Gemälde wird „lebendig“ – z. B. mit flackerndem Licht oder fliegenden Partikeln |

| Szenenerweiterung | Die KI ergänzt das Bild zu einer Szene mit Bewegung, z. B. Himmel, Wind, Regen |

Tools mit Bild-to-Video-Funktion

- RunwayML: „Motion Brush“ oder „Image-to-Video“ mit Kamerafahrten

- Pika Labs: Bild als Ausgangspunkt für animierte Szenen

- Kaiber: Wandelt Bilder in dynamische Clips mit Stilwahl

- D-ID: Lässt Porträts sprechen und blinzeln

- HeyGen: Avatar spricht mit echtem Bild als Basis

Aufgabe

Schritt 1: Bild auswählen

Wähle ein Bild aus, das du animieren möchtest. Du kannst:

- ein eigenes Foto verwenden (z. B. Landschaft, Porträt, Objekt)

- erstelle ein Bild mit KI

- ein lizenzfreies Bild von unsplash.com, pexels.com oder pixabay.com herunterladen

Schritt 2: Prompt schreiben

Formuliere einen klaren Video-Prompt, der beschreibt:

| Element | Beispiel |

|---|---|

| Szene / Subjekt | „Ein Berg bei Sonnenuntergang“ |

| Stil / Ästhetik | „wie ein Aquarellfilm“ |

| Bewegung / Dynamik | „langsamer Kameraflug von unten nach oben“ |

| Stimmung / Atmosphäre | „ruhig und majestätisch“ |

| Farbwelt / Licht | „in warmen Orangetönen mit goldener Lichtstimmung“ |

Schritt 3: Tool nutzen

Nutze eines der folgenden kostenlosen Tools, um dein Bild in ein Video zu verwandeln:

| Tool | Funktion | Zugang |

|---|---|---|

| Kaiber | Bild-zu-Video mit Stilwahl und Bewegung | kaiber.ai – Free Tier mit Credits |

| RunwayML | Motion Brush oder Image-to-Video | runwayml.com – Free Account |

| Pika Labs | Bild als Ausgangspunkt für animierte Szene | pika.art – Discord-Zugang erforderlich |

→ Teste dein Prompt im Tool und exportiere das Ergebnis (wenn möglich).

Schritt 4: Reflexion

Beantworte schriftlich oder im Plenum:

- Was hat gut funktioniert?

- Was war überraschend?

- Wie wirkt das Video im Vergleich zum Bild?

- Was würdest du beim nächsten Prompt anders machen?

Prompt-Design für Videos

Auch bei der Videogenerierung mit KI ist ein guter Prompt das A und O. Ein Video-Prompt beschreibt nicht nur was gezeigt werden soll, sondern auch wie – also mit welcher Bewegung, Kameraperspektive, Stimmung, Geschwindigkeit und visuellen Dynamik.

Je klarer, szenischer und atmosphärischer der Prompt, desto gezielter kann die KI ein animiertes Ergebnis erzeugen, das zur gewünschten Wirkung oder Story passt.

Elemente eines guten Video-Prompts

| Element | Beispiel |

|---|---|

| Szene / Subjekt | „Ein Roboter läuft durch eine verlassene Fabrik“, „Eine Tänzerin auf einem Berggipfel“ |

| Stil / Ästhetik | „im Cyberpunk-Stil“, „wie ein Aquarell-Animationsfilm“, „realistisch wie ein Kinotrailer“ |

| Bewegung / Dynamik | „langsamer Kameraschwenk“, „schneller Zoom auf das Gesicht“, „fliegende Perspektive über die Stadt“ |

| Stimmung / Atmosphäre | „bedrohlich“, „poetisch“, „hoffnungsvoll“, „surreal“ |

| Farbwelt / Licht | „in blauen Neonfarben“, „mit goldener Abendsonne“, „dunkel und neblig“ |

| Ton / Musik (optional) | „mit ruhiger Klaviermusik“, „elektronischer Beat“, „ohne Ton für meditative Wirkung“ |

| Details / Umgebung | „mit flackernden Monitoren“, „im Regen“, „umgeben von tanzenden Lichtpartikeln“ |

Beispiel-Prompt

„Eine futuristische Stadt bei Nacht, im Cyberpunk-Stil, mit fliegender Kamerafahrt über Neonlichter und Hochhäuser, begleitet von elektronischer Musik, Stimmung: geheimnisvoll und dynamisch.“

Kostenlose KI-Videotools

Text-zu-Video (Text Prompt → animiertes Video)

| Tool | Beschreibung |

|---|---|

| Pika Labs | Wandelt kurze Textbeschreibungen in animierte Clips um (z. B. für Social Media) |

| Kaiber | Erstellt visuelle Animationen aus Text oder Musik, mit Stilwahl |

| RunwayML | Bietet Text-to-Video-Funktion mit Stilfiltern und Bewegungseffekten |

Text-to-Speech (TTS) & Sprecherstimme

| Tool | Beschreibung |

|---|---|

| ElevenLabs (Free Tier) | Hochwertige synthetische Stimmen mit Emotion und Sprachwahl |

| Descript | Wandelt Text in Stimme um, inkl. Schnitt und Pausenentfernung |

| TTSMP3 | Einfache Online-TTS mit verschiedenen Stimmen und Sprachen |

Avatar-Animation & virtuelle Sprecher:innen

| Tool | Beschreibung |

|---|---|

| D-ID (Free Demo) | Erzeugt sprechende Avatare aus Text oder Audio |

| HeyGen (Free Credits) | Erstellt Videos mit realistischen Avataren und TTS |

| Synthesia (Testversion) | Professionelle Avatar-Videos, eingeschränkt kostenlos nutzbar |

Videoschnitt & automatische Bearbeitung

| Tool | Beschreibung |

|---|---|

| Descript | Bearbeitung durch Text – Video schneiden, Sprecher ersetzen, Untertitel erzeugen |

| Wisecut | Automatischer Schnitt, Pausenentfernung, Musikanpassung |

| Veed.io (Free Tier) | Online-Videoschnitt mit KI-Funktionen und Untertitelung |

Automatische Untertitelung & Transkription

| Tool | Beschreibung |

|---|---|

| Kapwing | KI-gestützte Untertitelung, einfache Bearbeitung |

| YouTube Studio | Automatische Untertitel für hochgeladene Videos |

| Veed.io | Echtzeit-Untertitelung und Übersetzung |

Formatanpassung & Plattformoptimierung

| Tool | Beschreibung |

|---|---|

| Kapwing | Anpassung an TikTok, Instagram, YouTube etc. mit Vorlagen |

| Canva Video Editor | Formatwahl für Social Media, Präsentationen, Websites |

| Lumen5 (Free Tier) | Automatische Formatoptimierung für Blog-to-Video-Projekte |

Inhaltsanalyse & Feedback

| Tool | Beschreibung |

|---|---|

| Pictory (Free Trial) | KI erkennt Struktur, Stimmung und macht Verbesserungsvorschläge |

| Wisecut | Bewertet Ton, Rhythmus und Schnittqualität automatisch |

| Lumen5 | Vorschläge zur Optimierung von Text, Bild und Format für Zielgruppen |

Aufgabe

Erstellt in kleinen Gruppen einen kurzen Videoclip (ca. 30–60 Sekunden), der sich mit einem selbstgewählten Thema rund um das Feld der Künstlichen Intelligenz befasst.

Themenideen:

- Ein Erklärvideo über die Funktionsweise eines Algorithmus (z. B. „Wie lernt ein Neuronales Netz?“)

- Eine Reportage über die Auswirkungen von KI auf einen bestimmten Beruf (z. B. „KI in der Medizin“)

- Eine „Mockumentary“ über einen Tag im Leben einer KI-gesteuerten Stadt

- Eine philosophische Frage: „Können Roboter Gefühle haben?“

Ziel: Zeigt in eurem Video, wie KI-Tools bei der Videoproduktion eingesetzt werden können, um eine Idee schnell und kreativ umzusetzen.

| Schritt | Was zu tun ist | Welche Konzepte werden angewandt? |

| 1. Skript und Storyboard | Wählt euer Thema aus und formuliert einen detaillierten Prompt, um ein KI-Modell (z. B. ChatGPT) zu bitten, ein Skript für euer 30-sekündiges Video zu schreiben. Das Skript soll in drei kurze Szenen unterteilt sein. | • Text-zu-Video • Storyboard-Erstellung |

| 2. Visuelle Generierung | Wählt eine Szene aus eurem Skript aus und erstellt mit einem Text-to-Video-Tool (z. B. Pika Labs, RunwayML) einen kurzen Videoclip. Experimentiert mit dem Prompt, um den Stil zu steuern (z. B. „im Cartoon-Stil“, „futuristisch“ oder „realistisch“). | • Bildgenerierung • Stilwahl • Visuelle Effekte |

| 3. Vertonung und Animation | Erstellt eine passende synthetische Stimme für euer Video. Nutzt ein Text-to-Speech-Tool (z. B. ElevenLabs). Wenn ihr möchtet, könnt ihr auch einen Avatar generieren (z. B. mit D-ID oder HeyGen), der eure generierte Stimme spricht. | • Text-to-Speech (TTS) • Avatar-Animation • Gesichtssynchronisation |

| 4. Schnitt und Fertigstellung | Ladet eure generierten Video- und Audio-Dateien in einen einfachen Videoschnitt-Editor (z. B. CapCut, Veed.io). Schneidet die Clips passend zusammen, fügt die Audiospur hinzu und lasst das Tool automatisch Untertitel generieren. | • Schnitt (Editing) • Automatische Untertitelung • Formatanpassung |

Deepfakes

Was sind Deepfakes?

Ein Deepfake ist ein künstlich erzeugtes, täuschend echtes Video oder Audio, das mithilfe von KI erstellt wurde. Ziel ist es, reale Personen oder Szenen so zu imitieren, dass sie echt wirken – obwohl sie es nicht sind.

Technische Grundlagen

KI-Modelle: GANs (Generative Adversarial Networks)

GANs sind eine spezielle Form von KI, die aus zwei Teilen besteht:

- Ein Generator, der versucht, realistische Bilder oder Videos zu erzeugen

- Ein Diskriminator, der prüft, ob das Ergebnis echt oder künstlich ist

Beide Modelle „trainieren sich gegenseitig“, bis der Generator täuschend echte Inhalte erzeugen kann. So entstehen Deepfakes, die kaum von echten Aufnahmen zu unterscheiden sind.

Trainingsdaten

Damit die KI lernen kann, braucht sie große Mengen an Daten:

- Bilder von Gesichtern in verschiedenen Perspektiven

- Videos mit Mimik, Gestik und Bewegung

- Audioaufnahmen mit Sprache, Tonlage und Emotion

Je mehr Daten vorhanden sind, desto realistischer wird das Ergebnis. Problematisch: Oft stammen diese Daten aus dem Internet – ohne Zustimmung der betroffenen Personen.

Gesichtssynchronisation

Ein zentrales Element von Deepfakes ist die automatische Anpassung des Gesichts an Sprache und Bewegung:

- Lippenbewegung wird synchron zur gesprochenen Sprache erzeugt

- Mimik (z. B. Lächeln, Stirnrunzeln) wird passend zur Emotion eingeblendet

- Stimme kann durch Text-to-Speech künstlich erzeugt oder kopiert werden

Das Ergebnis: Eine virtuelle Person spricht scheinbar echt – obwohl sie nie existiert hat oder nie das Gesagte gesagt hat.

Beispiele für Deepfakes

- Prominente in gefälschten Interviews – Ein KI-generiertes Video zeigt z. B. einen Schauspieler, der scheinbar eine politische Meinung äußert – obwohl er das nie getan hat.

- Werbung mit künstlich erzeugten Testimonials – Ein Unternehmen nutzt Deepfake-Technik, um eine bekannte Person scheinbar für ein Produkt werben zu lassen – ohne echte Zusammenarbeit.

- Satire-Videos mit manipulierten Politikerreden – In der Satire werden Politiker:innen mit Deepfake-Technik in absurde Situationen gebracht – z. B. tanzen, singen oder Unsinn reden.

- Filmproduktionen mit digital verjüngten Schauspieler:innen – In Hollywood werden Schauspieler:innen digital verjüngt oder ersetzt – z. B. für Rückblenden oder Szenen mit verstorbenen Darsteller:innen.

Aufgabe

Schaut euch das Video „Kannst Du reale Videos von KI Fakes unterscheiden? AI Film und Video Update #8“ aufmerksam an.

Teil A: Der „Fake-Detektor“-Test (Während des Videos)

- Eigener Test: Der Video-Ersteller zeigt verschiedene kurze Videoclips und fordert euch auf, zu entscheiden, ob diese echt (mit Kamera gedreht), KI-generiert (Fake) oder halb-echt (Hybrid) sind.

- Führt während des Videos eine Liste mit den Nummern der gezeigten Clips (z. B. Clip 1, Clip 2, Clip 3…).

- Schreibt neben jeden Clip eure eigene Vermutung (Echt, KI-generiert, Halb-echt) und begründet kurz, warum ihr das glaubt. Achtet auf Details, die euch auffallen!

- Auflösung und Vergleich: Nach der Auflösung im Video (ab ca. [03:44]) tragt ihr die tatsächliche Klassifizierung des Video-Erstellers ein.

- Vergleicht eure Vermutungen mit der tatsächlichen Auflösung.

- Notiert euch für jeden falsch erkannten Clip, was euch in die Irre geführt hat oder welche Hinweise ihr übersehen habt.

Teil B: Die 5 Indizien für KI-Fakes (Nach der Auflösung)

Das Video präsentiert fünf Hauptindizien, an denen man KI-generierte Videos erkennen kann (ab ca. [05:34]).

- Zusammenfassung der Indizien: Listet die fünf genannten Indizien auf und erklärt jedes kurz in eigenen Worten.

- Analyse konkreter Fehler: Wählt drei der im Video gezeigten fehlerhaften KI-Clips aus.

- Beschreibt für jeden dieser drei Clips, welche spezifischen Fehler ihr erkennt (z. B. bei den Händen, Objekten im Hintergrund, Bewegungen) und ordnet diese den gelernten Indizien zu.

- Erklärt, warum diese Fehler für die KI-Generierung typisch sind.

- Kritische Beobachtung: Der Video-Ersteller weist darauf hin, dass KI-Modelle immer besser werden und auch das Imperfekte imitieren können (z. B. Kamerawackler).

- Diskutiert in Kleingruppen: Warum macht es die Erkennung von KI-Fakes schwieriger, wenn KI auch Imperfektionen nachbildet? Welche neuen Herausforderungen entstehen dadurch für uns als Betrachter?

Teil C: Reflexion und Ausblick

Fazit für Medienkonsum: Was sind eure drei wichtigsten Erkenntnisse aus diesem Video für den bewussten Umgang mit Videos im Internet?

Alltägliche „Fakes“: Das Video betont, dass KI-Fakes nicht nur Deepfakes von Prominenten sind, sondern auch alltägliche Szenen betreffen.

Nennt zwei mögliche Szenarien, in denen solche alltäglichen KI-Fakes problematisch sein könnten (z. B. in Nachrichten, sozialen Medien oder Werbung).

Diskutiert, welche Auswirkungen dies auf unser Vertrauen in visuelle Medien haben könnte.

Recht & Ethik bei Deepfakes

Rechtliche Fragen

Urheberrecht: Wer besitzt das Bild, die Stimme, das Gesicht?

- Bilder und Videos unterliegen dem Urheberrecht, wenn sie kreativ erstellt wurden. → Beispiel: Ein Foto von dir gehört dir – andere dürfen es nicht einfach verwenden.

- Stimme und Gesicht sind keine „Werke“ im klassischen Sinne, aber sie fallen unter das Recht am eigenen Bild und Ton. → Niemand darf deine Stimme oder dein Gesicht ohne Zustimmung in einem Deepfake verwenden.

- KI-generierte Inhalte sind rechtlich umstritten: → Wer ist Urheber eines Deepfake-Videos – die KI, die Nutzerin, das Tool? → In vielen Ländern gilt: Der Mensch, der das Tool bedient, trägt die Verantwortung.

Diskussionsimpuls: „Wenn ich ein KI-Video mit einer berühmten Stimme erstelle – ist das erlaubt?“

Persönlichkeitsrechte: Schutz vor Missbrauch

- Jede Person hat das Recht, selbst zu entscheiden, wie sie dargestellt wird. → Deepfakes können dieses Recht verletzen, z. B. durch falsche Aussagen oder peinliche Szenen.

- Besonders kritisch:

- Politiker:innen in manipulierten Reden

- Privatpersonen in kompromittierenden Situationen

- Kinder und Jugendliche in Fake-Videos

- In Deutschland gilt: → Die Veröffentlichung eines Deepfakes ohne Zustimmung kann strafbar sein – z. B. als Verleumdung, üble Nachrede oder Verletzung des Persönlichkeitsrechts.

Reflexionsfrage: „Wie würdest du dich fühlen, wenn dein Gesicht in einem fremden Video auftaucht?“

Plattformregeln & Kennzeichnungspflicht

- Viele Plattformen haben eigene Regeln für KI-Inhalte:

| Plattform | Regelung (Stand 2025) |

|---|---|

| YouTube | KI-generierte Inhalte müssen gekennzeichnet werden, v. a. bei realistisch wirkenden Personen |

| TikTok | Deepfakes mit echten Personen sind ohne Zustimmung verboten; KI-Label empfohlen |

| KI-Inhalte dürfen nicht täuschen; Meta testet automatische Erkennung und Labeling |

- Verstöße können zur Löschung, Sperrung oder sogar rechtlichen Konsequenzen führen.