2. Unterrichtsblock

Wiederholung: Was ist KI und wie lernt sie?

1. Was ist Künstliche Intelligenz?

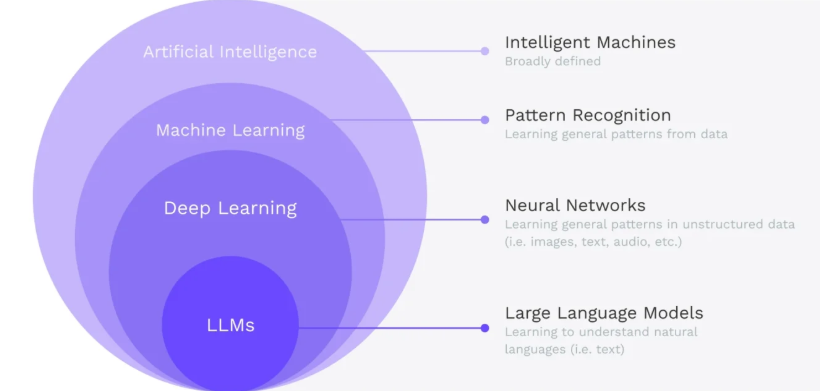

KI ist ein Teilbereich der Informatik, bei dem Programme eigenständig Probleme lösen. Sie unterscheidet sich von klassischer Programmierung dadurch, dass sie nicht nur Regeln befolgt, sondern aus Daten lernt. Man spricht von „schwacher KI“ bei spezialisierten Anwendungen wie Sprachassistenten oder Bilderkennung, und von „starker KI“, wenn menschenähnliches Denken angestrebt wird.

2. Wie funktioniert maschinelles Lernen?

Maschinelles Lernen ist die Grundlage moderner KI. Dabei lernt ein Modell aus Beispieldaten, um Muster zu erkennen und Entscheidungen zu treffen. Es gibt drei Hauptformen:

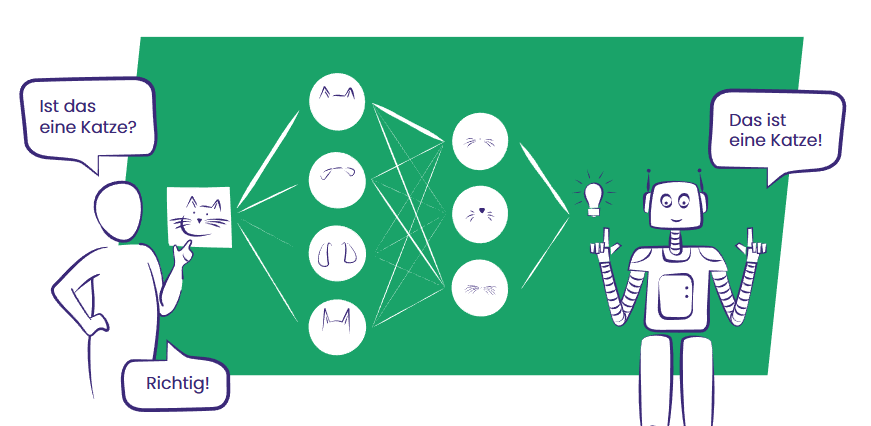

- Überwachtes Lernen: Das Modell lernt anhand von gelabelten Daten, z. B. zur Klassifikation (z. B. „Katze“ vs. „Hund“) oder Regression (z. B. Temperaturvorhersage).

- Unüberwachtes Lernen: Das Modell erkennt Strukturen in Daten ohne vorgegebene Labels, z. B. durch Clustering.

- Bestärkendes Lernen: Das Modell lernt durch Belohnung und Bestrafung, z. B. bei der Steuerung von Robotern oder Spielstrategien.

Ergänzend dazu gibt es fortgeschrittene Lernstrategien:

- Aktives Lernen: Das Modell wählt gezielt Daten aus, bei denen es sich unsicher ist, um möglichst effizient zu lernen.

- Meta-Learning: Das Modell erkennt, welche Lernstrategien bei bestimmten Aufgaben besonders erfolgreich sind – es lernt also, wie es besser lernen kann.

3. Welche Lernmethoden gibt es?

Die drei zentralen Methoden des maschinellen Lernens sind:

- Klassifikation: Daten werden festen Klassen zugeordnet (z. B. Tierarten, Krankheitsbilder).

- Regression: Das Modell sagt kontinuierliche Werte voraus (z. B. Temperatur, Preisentwicklung).

- Clustering: Daten werden in Gruppen eingeteilt, ohne dass die Gruppen vorher bekannt sind (z. B. Spam-Bots erkennen).

Diese Methoden bilden die Grundlage für viele KI-Anwendungen im Alltag – von Suchmaschinen über medizinische Diagnosen bis hin zu Empfehlungssystemen.

Vertiefung: Architektur neuronaler Netze

In diesem Abschnitt geht es um die wichtigsten Arten von künstlichen neuronalen Netzen – also die Grundbausteine moderner KI. Von einfachen Modellen, die Dinge wie Zahlen oder Kategorien erkennen, bis hin zu komplexen Sprachsystemen wie ChatGPT. Die verschiedenen Netztypen werden verständlich erklärt und mit typischen Einsatzbereichen verknüpft – z. B. Bilderkennung, Sprachverarbeitung oder Textgenerierung. Ziel ist, zu verstehen, wie KI Informationen verarbeitet, Muster erkennt und daraus sinnvolle Ergebnisse ableitet – und wo diese Technik im Alltag und Beruf eingesetzt wird.

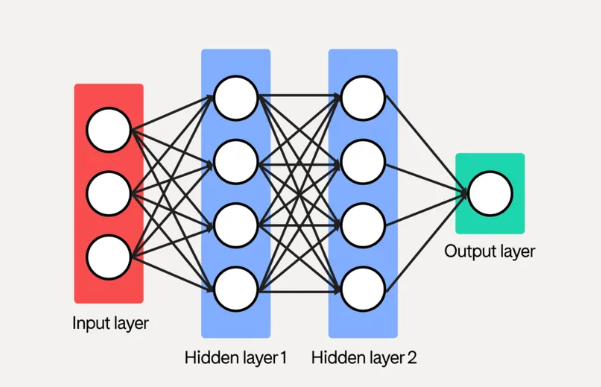

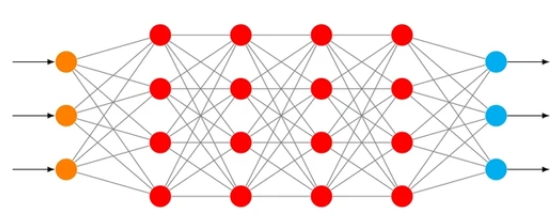

1. Künstliche neuronale Netze (ANN)

- Einfache Netzwerke mit Eingabe-, versteckten und Ausgabeschichten

- Grundlage für viele KI-Anwendungen

- Verarbeiten strukturierte Daten wie Zahlen oder Kategorien

Einsatzfelder:

- Klassifikation (z. B. Spamfilter, Ziffernerkennung)

- Grundlagenmodell für maschinelles Lernen

- Einstieg in die Architektur neuronaler Netze

Tools & Plattformen:

- Teachable Machine (Google) – visuelle Klassifikation ohne Programmierkenntnisse

- TensorFlow Playground – interaktive Visualisierung einfacher Netzwerke

- Scikit-learn – Python-Bibliothek für klassische ML-Modelle

2. Tiefe neuronale Netze (DNN)

- Erweiterte ANN mit mehreren versteckten Schichten

- Erkennen komplexe Muster und Zusammenhänge

- Können abstrakte Merkmale aus Rohdaten ableiten

Einsatzfelder:

- Sprachverarbeitung

- Bilderkennung

- Textklassifikation

- Vorhersagemodelle

Tools & Plattformen:

- Keras – High-Level-API für tiefe Netze, ideal für Einsteiger

- Google Colab – kostenlose Umgebung für DNN-Experimente

- Hugging Face Transformers – Modelle für Textklassifikation und mehr

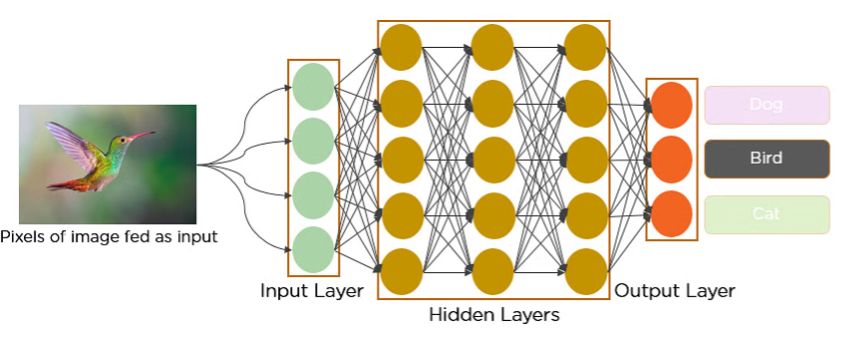

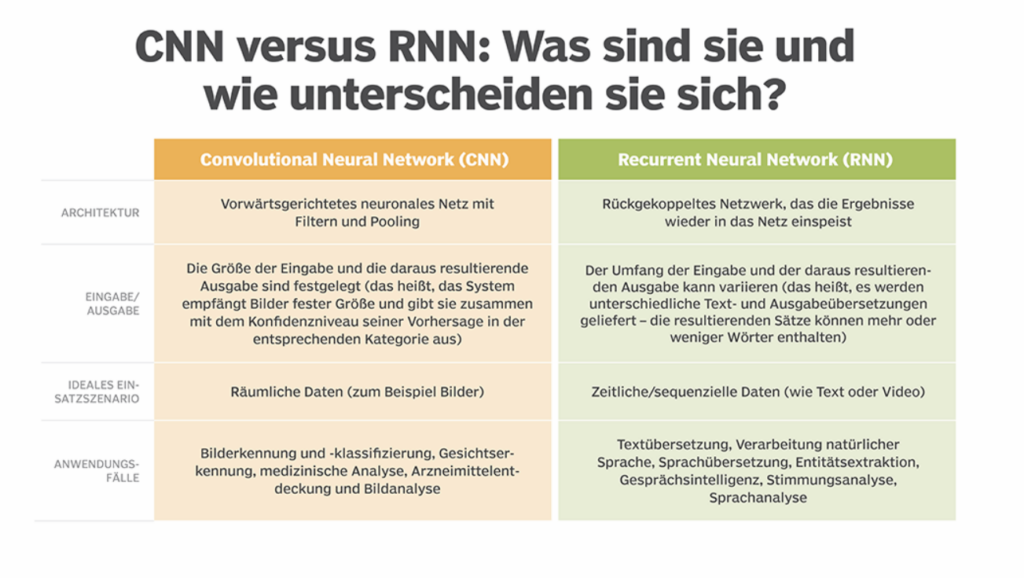

3. Convolutional Neural Networks (CNN)

- Spezialisierte Netze für Bilddaten

- Arbeiten mit Filtern, um Kanten, Farben und Formen zu erkennen

- Besonders effizient bei visuellen Aufgaben

Einsatzfelder:

- Bilderkennung (z. B. Hautanalyse, Verkehrszeichen)

- Medizinische Diagnostik

- Gesichtserkennung

- Objektklassifikation

Tools & Plattformen:

- Runway ML – KI-gestützte Bildanalyse und visuelle Projekte

- Roboflow – Trainingsdaten für Bildklassifikation und Objekterkennung

- Fast.ai – praxisnahe Bibliothek für Deep Learning mit Fokus auf CNNs

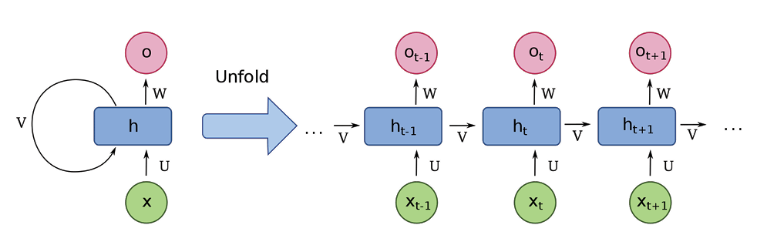

4. Recurrent Neural Networks (RNN)

- Netzwerke mit „Gedächtnis“ – berücksichtigen vorherige Eingaben

- Verarbeiten sequenzielle Daten wie Sprache oder Zeitreihen

- Varianten wie LSTM und GRU verbessern Langzeitgedächtnis

Einsatzfelder:

- Sprachmodelle

- Textanalyse

- Wetterdaten, Aktienkurse

- Musik- und Bewegungsdaten

Tools & Plattformen:

- Magenta (Google) – KI-generierte Musik und kreative Sequenzen

- NeuralForecast – Zeitreihenanalyse mit Deep Learning

- PyTorch – flexible Frameworks für RNNs und LSTM-Modelle

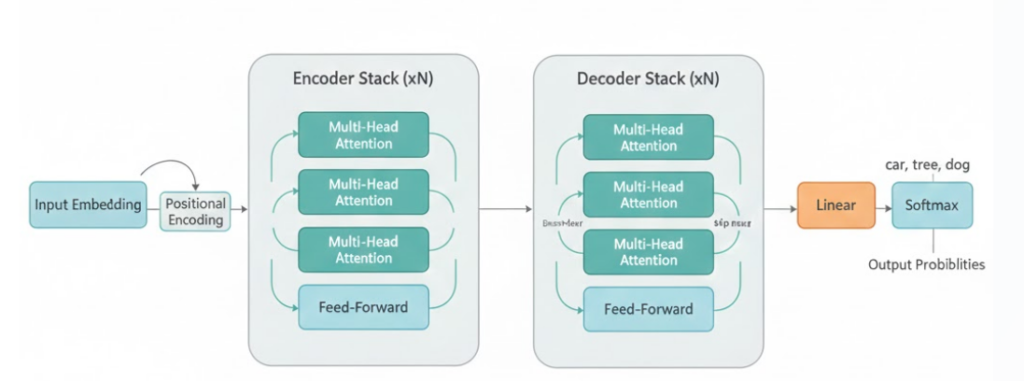

5. Transformer-Modelle

- Verarbeiten alle Eingaben gleichzeitig („Self-Attention“)

- Erkennen semantische Zusammenhänge über große Textmengen hinweg

- Grundlage für moderne Sprach-KI

Einsatzfelder:

- Übersetzungen

- Textverständnis

- Chatbots

- Zusammenfassungen

Tools & Plattformen:

- Hugging Face Transformers – Zugriff auf vortrainierte Transformer-Modelle

- OpenAI Playground – direkte Interaktion mit GPT-Modellen

- Google Vertex AI – skalierbare KI-Modelle für Unternehmen

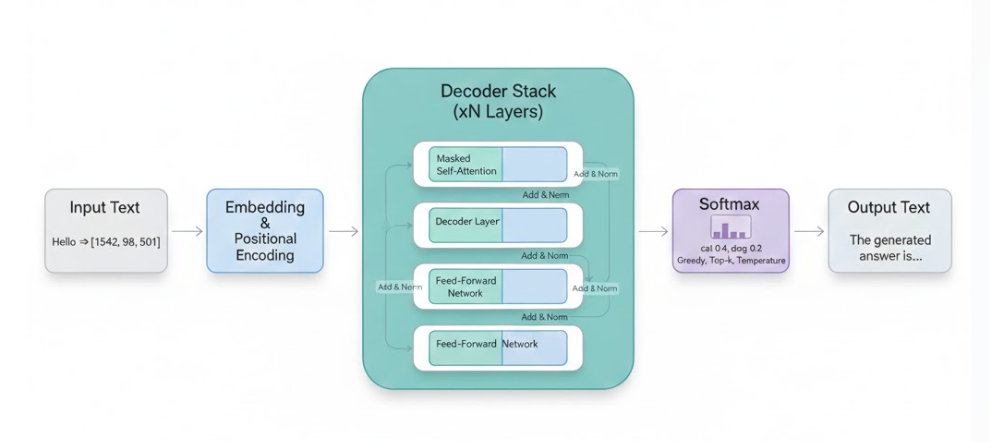

6. LLM (Large Language Models)

1. Was sind LLMs?

- Definition: „Large Language Models“ = sehr große KI-Sprachmodelle

- Basieren auf Transformer-Architektur

- Trainiert mit Milliarden von Textdaten

2. Wie funktionieren LLMs?

- Textverarbeitung über Wahrscheinlichkeiten

- Kein echtes „Verstehen“, sondern Mustererkennung

- Prompting als Steuerung: Wie beeinflusst Sprache die Ausgabe?

3. Was können LLMs?

- Textgenerierung: Schreiben, Zusammenfassen, Übersetzen

- Dialogsysteme: Chatbots, Rechercheagenten

- Code-Erstellung: z. B. HTML, Python

- Vereinfachung & Stilwechsel: leichte Sprache, Fachsprache

4. Wo werden LLMs eingesetzt?

- Bildung: Lernhilfen, Textvereinfachung

- Beruf: E-Mails, Dokumentation, Kundenservice

- Kreative Felder: Storytelling, Design, Musik

- Reflexion: „Was kann ein LLM besser als ich – und was nicht?“

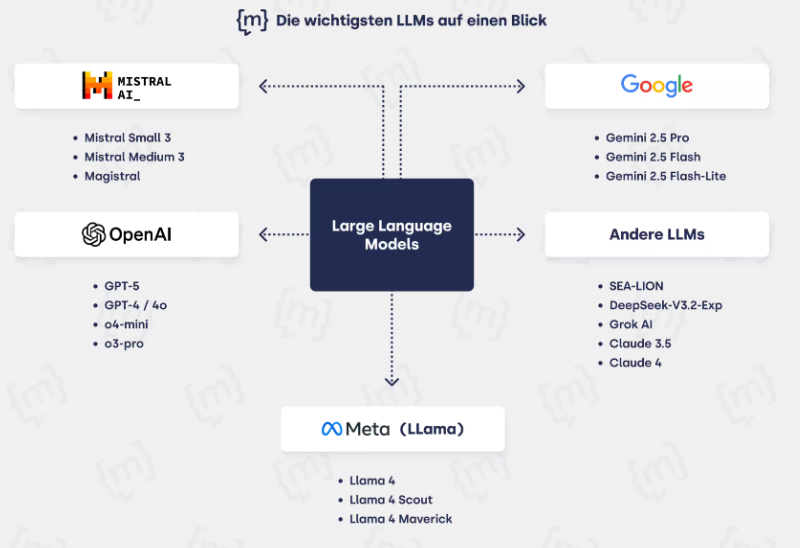

Beispiele für LLMs

| Modellname | Anbieter | Besonderheit |

|---|---|---|

| GPT-4 / GPT-3.5 | OpenAI | Vielseitig, dialogfähig, kreativ |

| Claude | Anthropic | Sicherheitsfokus, lange Kontexte |

| Gemini | Google DeepMind | Multimodal, Google-Integration |

| Mistral / Mixtral | Mistral AI | Open-Source, leichtgewichtig |

| LLaMA / Code LLaMA | Meta | Forschung, Codefokus |

ChatGPT

Arbeiten mit ChatGPT

Nachdem du nun verstanden hast, was ein Large Language Model (LLM) ist und wie es grundsätzlich funktioniert, schauen wir uns jetzt ein konkretes Beispiel an: ChatGPT.

ChatGPT ist ein dialogfähiges KI-System, das auf einem LLM basiert – genauer gesagt auf einem sehr leistungsfähigen Transformer-Modell, das mit riesigen Textmengen trainiert wurde. Es erkennt Muster, berechnet Wahrscheinlichkeiten für passende Wortfolgen und reagiert auf Eingaben in natürlicher Sprache. Dabei „versteht“ es Inhalte nicht wie ein Mensch, sondern verarbeitet sie statistisch.

Die Steuerung von ChatGPT erfolgt über sogenannte Prompts – also Texteingaben, mit denen du Aufgaben, Fragen oder Anweisungen formulierst. Ein Prompt kann eine Bitte, eine Beschreibung oder eine konkrete Frage sein. Je klarer und strukturierter du deinen Prompt formulierst, desto hilfreicher und präziser fällt die Antwort aus.

ChatGPT erkennt keine Bedeutung im menschlichen Sinne, sondern berechnet, welche Wortfolgen wahrscheinlich auf deine Eingabe folgen. Deshalb ist es wichtig, Prompts zielgerichtet, eindeutig und kontextbezogen zu gestalten.

Beispiel für einen unklaren Prompt: „Erzähl mir was über KI.“

Beispiel für einen guten Prompt: „Erkläre mir in drei Sätzen, wie ein neuronales Netz funktioniert und wofür es eingesetzt wird.“

Beispiel Uni Freiburg-Neuronales Netz: https://ad-research.cs.uni-freiburg.de/nn-demo-1/

ChatGPT in Python einbinden

Die Einbindung von ChatGPT erfordert eine Schittstelle zu OpenAI. Diese wird über einen sogenannten API-key hergestellt.

- Um den API-key zu erhalten, wird ein Account bei OpenAI benötigt.

- Nun muss über das Terminal mit folgendem Befehl OpenAI installiert werden:

pip3 install openai - Nachdem OpenAI installiert ist, sollte noch sichergestellt werden, dass Python aktiviert ist

Aufgabe 1: Code ausführen & testen

Wenn Punkt 1. – 3. erfolgreich verlaufen sind, kann der folgende Code ausgeführt werden.

Teste verschiedene Eingaben. Probiere auch eigene Prompts aus – z. B. Fragen, Anweisungen oder kreative Ideen.

# Überarbeitet 28.12.2025

# Änderung des alten Codes, weil die frühere OpenAI‑API abgeschaltet wurde.

# Der neue Code nutzt jetzt die aktuelle API-Struktur mit OpenAI(),

# sowie client.chat.completions.create() für Chat-Anfragen.

from openai import OpenAI

client = OpenAI(api_key="DEIN_API_KEY")

def chat_mit_gpt(benutzer_eingabe):

antwort = client.chat.completions.create(

model="gpt-4o-mini",

messages=[

{"role": "system", "content": "Du bist ein hilfreicher Assistent."},

{"role": "user", "content": benutzer_eingabe}

]

)

return antwort.choices[0].message["content"]

while True:

benutzer_eingabe = input("Gib deine Nachricht ein: ")

if benutzer_eingabe:

antwort = chat_mit_gpt(benutzer_eingabe)

print(f"ChatGPT: {antwort}")

Aufgabe 2: Modelle und ChatCompletions

Schaue die OpenAI-Referenz zu den Modellen an: https://platform.openai.com/docs/models

- Welche Modelle bietet OpenAI aktuell an (z. B. GPT-3.5, GPT-4, GPT-4o)?

- Was unterscheidet diese Modelle in Bezug auf Leistung, Geschwindigkeit und Kosten?

- Für welche Anwendungsbereiche eignen sich die jeweiligen Modelle besonders?

Schaue dir nun die ChatCompletions an: https://platform.openai.com/docs/guides/chat-completions/getting-started

- Was ist ein „Prompt“ und wie wird er übergeben?

- Welche Rollen gibt es im Nachrichtenverlauf (

system,user,assistant) und welche Funktion haben sie? - Was bedeutet „Temperature“ und wie beeinflusst sie die Antwort?

- Was ist eine „Completion“ und wie wird sie im Code verarbeitet?

Aufgabe 3

Erstelle im Python-Programm mit Hilfe von ChatGPT eine Webseite mit Header, Footer und mehreren Kacheln im Flexbox-Layout.

Erstelle ein Referat zu den Grundbegriffen rund um ChatGPT:

Grundbegriffe die unbedingt erklärt werden müssen:

- LLMs

- Prompts (Systempromt und normale Prompts)

- Temperatur

- Fine-Tuning

- Agenten

- CustomGPTs

- Streaming (im Kontext von LLMs)

- Tokens

- Completions

- Vektordatenbank

Versuche die o.g. Begriffe im Zusammenhang zu verstehen, um sie gut erklären zu können.

Weiter Themen, die im Referat enthalten sein müssen:

- Training und Datensätze: Eine Erklärung, wie ChatGPT mit großen Textdatensätzen trainiert wird, um Sprachverständnis und -generierung zu erlernen.

- Natural Language Processing (NLP): Allgemeines Wissen über NLP-Techniken und deren Anwendungen in ChatGPT.

- Kontext: Wie ChatGPT den Kontext eines Gesprächs beibehält oder verliert, und wie dies die Antworten beeinflusst.

- API-Zugriff: Möglichkeiten der Integration von ChatGPT in Anwendungen über APIs.

- Beispiele für Integrationen: Wie ChatGPT-Modelle in reale Anwendungen integriert und skaliert werden.

- Updates und Versionen von GPT: Überblick über die verschiedenen Versionen und deren Fortschritte von GPT-1 bis zu den neuesten Modellen.

Form: Powerpoint Präsentation

Erlaubte Werkzeuge: ChatGPT